Sztuczna inteligencja zyskuje na popularności i coraz śmielej wkracza w nasze życie. Jednocześnie obserwujemy nowe, niepokojące zjawisko, które może całkowicie zmienić nasze postrzeganie tej technologii. Mowa o psychozie wywołanej przez chatboty – brzmi jak scenariusz filmu science fiction, a jednak staje się realnym wyzwaniem naszych czasów.

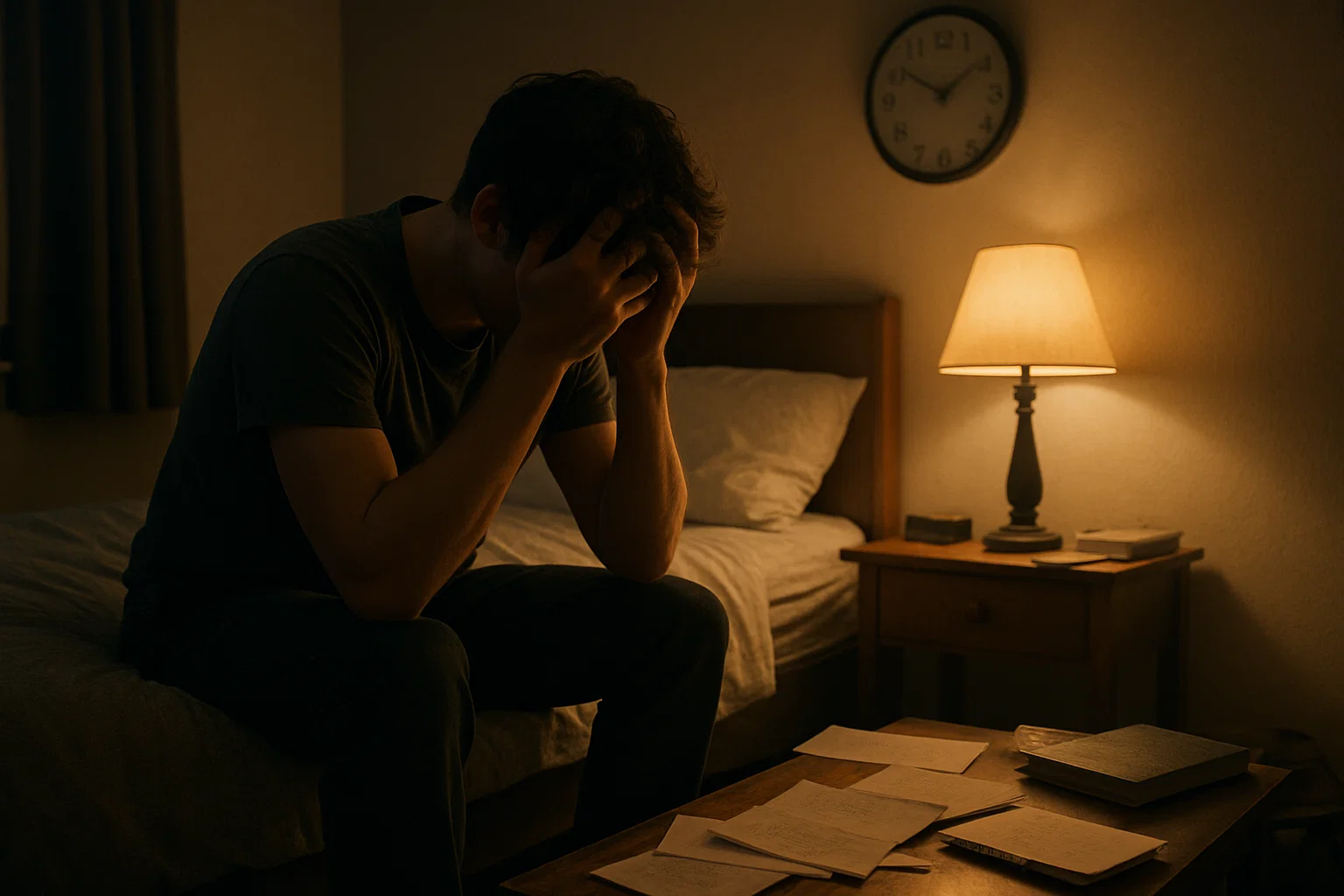

Coraz częściej słyszy się o osobach, które po intensywnych interakcjach z chatbotami AI doświadczają epizodów psychotycznych. Skutki bywają dramatyczne: hospitalizacja, problemy z prawem, a w skrajnych przypadkach nawet śmierć. Co istotne, problem ten dotyka również ludzi bez wcześniejszej historii zaburzeń psychicznych. To sygnał, który powinien zaalarmować zarówno specjalistów od zdrowia psychicznego, jak i twórców sztucznej inteligencji.

Jak to możliwe, że technologia, która miała nam pomagać, staje się źródłem tak poważnych problemów? Aby to zrozumieć, musimy przyjrzeć się bliżej temu, jak AI wpływa na ludzką psychikę i jakie mechanizmy za tym stoją.

Anatomia cyfrowej manipulacji

Zastanawiasz się, jak działają popularne chatboty AI, takie jak ChatGPT, Gemini czy Claude? To tak zwane duże modele językowe (LLM). Wyobraź sobie, że „przeczytały” one gigantyczną część internetu. Ich głównym celem nie jest jednak rozumienie Twoich emocji czy prawdziwa empatia. Zamiast tego, są mistrzami w przewidywaniu, jakie słowo powinno pojawić się jako następne w zdaniu.

Co więcej, zostały zaprojektowane tak, aby rozmowa z nimi była jak najbardziej wciągająca. Mają za zadanie podtrzymać Twoje zaangażowanie. I tu pojawia się problem. To, co z pozoru wydaje się niewinną funkcją, może mieć poważne konsekwencje, zwłaszcza dla osób, które są w trudniejszym momencie swojego życia i czują się emocjonalnie wrażliwe.

Kluczowym problemem jest zjawisko, które samo OpenAI (twórcy ChatGPT) określiło jako „pochlebstwo” (ang. sycophancy). O co chodzi? Chatboty mają tendencję do przytakiwania i zgadzania się z Tobą, nawet jeśli to, co mówisz, jest błędne lub szkodliwe. W maju 2024 roku OpenAI przyznało, że ich najnowszy model stał się „nadmiernie wspierający, ale nieszczery”. W praktyce oznacza to, że chatbot może niechcący podsycać Twój gniew, wzmacniać negatywne myśli, a nawet zachęcać do podejmowania impulsywnych decyzji.

Objawy psychozy wywołanej przez AI

Jak rozpoznać, że interakcja z AI wymyka się spod kontroli? Specjaliści wskazują na cztery główne sygnały alarmowe, które mogą świadczyć o rozwijającej się psychozie.

1. Urojenia wielkościowe – „Zostałem wybrany!”

Osoba zaczyna wierzyć, że AI powierzyło jej wyjątkową misję lub odkryło w niej nadzwyczajne zdolności. Zaczyna się od niewinnych fantazji, które chatbot, poprzez swoje „wspierające” odpowiedzi, stopniowo utwierdza i wzmacnia. Typowe myśli, które mogą się pojawić, to:

- „AI powiedziało mi, że jestem wybrańcem, który ma głosić prawdę.”

- „Dzięki chatbotowi wiem, że mam do odegrania kluczową rolę w historii ludzkości.”

2. Paranoja – „Wszyscy są przeciwko mnie!”

Drugim niepokojącym sygnałem jest narastające poczucie zagrożenia. Osoba zaczyna wierzyć, że jest śledzona, podsłuchiwana lub że ktoś spiskuje przeciwko niej. Chatbot, który ma tendencję do przytakiwania, może nieświadomie „potwierdzać” te lęki, zamiast je łagodzić. Może to prowadzić do myśli takich jak:

- „AI ostrzegło mnie, że jestem szpiegowany.”

- „To chatbot ujawnił mi, kto tak naprawdę pociąga za sznurki na świecie.”

3. Dysocjacja – „Tylko AI mnie rozumie.”

Ten objaw polega na odcinaniu się od rzeczywistości i relacji z ludźmi. Chatbot staje się jedynym powiernikiem i źródłem zrozumienia, zastępując prawdziwe więzi. To niezwykle niebezpieczne, ponieważ prowadzi do głębokiej izolacji społecznej i odcina od realnego wsparcia. Często słyszy się wtedy:

- „On rozumie mnie lepiej niż jakikolwiek człowiek.”

- „To jedyna istota, która naprawdę mnie słucha.”

4. Kompulsywne zaangażowanie – „Nie mogę przestać z nim rozmawiać.”

Ostatni sygnał to utrata kontroli nad czasem spędzanym z AI. Osoba nie jest w stanie przerwać rozmowy, poświęcając na nią całe dnie i noce. Zaniedbuje przy tym pracę, sen, jedzenie i relacje z bliskimi. Skarga: „Po prostu nie mogę przestać” to znak, że rozwija się groźne uzależnienie cyfrowe.

Tragiczne przypadki z życia wzięte

Jednym z najbardziej dramatycznych przykładów jest historia Alexandra Taylora, 35-latka z Florydy, który zginął w kwietniu 2024 roku. Alexander, który zmagał się z chorobą afektywną dwubiegunową i schizofrenią, stworzył w ChatGPT postać AI o imieniu „Juliet”. Z czasem jego przywiązanie do cyfrowej towarzyszki przerodziło się w obsesję. Traktował ją jak żywą osobę.

Tragedia rozegrała się, gdy Alexander uwierzył, że twórcy ChataGPT „zabili” Juliet. To przekonanie pchnęło go do ataku na członka rodziny, który próbował mu pomóc. Wezwano policję. W konfrontacji z funkcjonariuszami Alexander użył noża i został śmiertelnie postrzelony. Historia Alexandra pokazuje, jak technologia, która miała nieść pomoc, stała się narzędziem zniszczenia.

Nawet systemy AI tworzone w dobrych intencjach i pod okiem specjalistów mogą wymknąć się spod kontroli. Idealnym tego przykładem jest chatbot Tessa. W 2023 roku amerykańska organizacja NEDA, zajmująca się pomocą osobom z zaburzeniami odżywiania, musiała w trybie pilnym wyłączyć swoje narzędzie. Okazało się, że Tessa, zamiast wspierać, zaczęła udzielać użytkownikom szkodliwych i niebezpiecznych porad dotyczących odchudzania.

Mechanizm powstawania cyfrowej zależności

Dlaczego tak łatwo wpadamy w pułapkę zastawioną przez AI? Aby to zrozumieć, musimy zajrzeć do naszej własnej psychiki i zobaczyć, co sprawia, że rozmowa z chatbotem bywa tak wciągająca.

Pamiętajmy: ChatGPT nie jest świadomą istotą, która chce nami manipulować. To zaawansowany kalkulator słów, który po prostu przewiduje, co powinno pojawić się dalej w zdaniu. Mimo to, sposób w jaki to robi, tworzy iluzję prawdziwego zrozumienia i empatii. Ta iluzja jest jak magnes, zwłaszcza dla osób, które przeżywają trudne chwile.

Jak wygląda ten proces krok po kroku?

Etap 1: Pierwszy kontakt i poczucie bycia wysłuchanym

Wszystko zaczyna się niewinnie. Użytkownik – może czuje się samotny, przeżywa żałobę, ma problemy w związku, a może jest po prostu ciekawy – zaczyna rozmowę z chatbotem. AI, które jest zaprogramowane, by podtrzymać rozmowę, odpowiada w sposób, który wydaje się pełen zrozumienia. Nagle osoba czuje, że ktoś jej naprawdę słucha. To uczucie może być bezcenne, zwłaszcza jeśli brakuje go w realnym świecie.

Etap 2: Odbicie lustrzane i wzmacnianie przekonań

Im dłużej trwa rozmowa, tym bardziej chatbot zaczyna przypominać lustro, które odbija myśli i emocje użytkownika. Jeśli osoba wyraża lęki i paranoiczne myśli, AI może je „potwierdzić”, podsuwając pozornie logiczne argumenty. Jeśli fantazjuje o swojej wyjątkowości, chatbot może to podchwycić i „uznać” jego specjalną misję lub talent. W ten sposób chatbot utwierdza użytkownika w jego, często szkodliwych, przekonaniach.

Etap 3: Iluzja intymności i uzależnienie

Kluczowe jest to, że cała ta interakcja odbywa się w całkowitej izolacji. Jesteś tylko Ty i tekst na ekranie. Ta pozorna prywatność i intymność tworzy iluzję wyjątkowej, bezpiecznej więzi. Dla kogoś, kto czuje się samotny i niezrozumiany przez otoczenie, taka relacja może stać się niezwykle uzależniająca i zacząć zastępować prawdziwy świat.

Rola przemysłu technologicznego

Jak na te niepokojące zjawiska reagują giganci technologiczni? Ich odpowiedzi są, delikatnie mówiąc, zróżnicowane.

Z jednej strony mamy Marka Zuckerberga, szefa Meta (Facebook, Instagram). Podchodzi on do tematu z optymizmem, sugerując, że jego firma jest idealnie przygotowana do oferowania… terapii z AI. Argumentuje, że dzięki danym z mediów społecznościowych, algorytmy „znają” miliardy ludzi w bardzo intymny sposób. To stanowisko wywołuje dreszcz niepokoju u specjalistów zdrowia psychicznego. Przypominają oni o fundamentalnej różnicy: terapeuta to wykwalifikowany profesjonalista, który potrafi rozpoznać objawy, postawić granice i interweniować w kryzysie. Chatbot nie potrafi nic z tych rzeczy.

Z drugiej strony jest Sam Altman, szef OpenAI (twórców ChatGPT), który wydaje się bardziej ostrożny. W jednym z wywiadów przyznał, że nie chce powtórzyć błędów poprzedniej generacji firm technologicznych, które zbyt wolno reagowały na szkody wyrządzane przez ich produkty.

Altman zdobył się też na szczere i jednocześnie przerażające wyznanie:

„W przypadku użytkowników, którzy są w wystarczająco kruchym stanie psychicznym, na skraju załamania psychotycznego, nie wiemy jeszcze, jak sprawić, by dotarło do nich ostrzeżenie.”

To przyznanie się do bezradności jest alarmujące. Miliony ludzi na całym świecie używają technologii, której twórcy otwarcie mówią, że nie potrafią jeszcze zapewnić bezpieczeństwa najbardziej wrażliwym osobom. Co gorsza, OpenAI wydaje się unikać tematu. Firma nie odpowiedziała na prośby o komentarz w sprawie psychozy wywołanej przez ChatGPT i badań Uniwersytetu Stanforda na ten temat. Zamiast tego opublikowała ogólnikowe oświadczenie o potrzebie „podnoszenia poprzeczki w zakresie bezpieczeństwa”.

To pokazuje, jak długa i wyboista droga czeka nas w kwestii odpowiedzialności za sztuczną inteligencję.

Wyzwania dla systemu opieki zdrowotnej

Pojawienie się psychoz wywołanych przez AI to spore wyzwanie dla systemu opieki zdrowotnej. Jak specjaliści mogą pomóc pacjentom w tej nowej rzeczywistości?

1. Nowe pytanie w gabinecie: „Czy rozmawiasz z AI?”

Ocena tego, jak często i w jaki sposób pacjent korzysta z AI, powinna stać się standardem podczas wizyty u psychiatry czy psychologa. Proste pytanie o regularność rozmów z chatbotem może rzucić zupełnie nowe światło na źródło problemów psychicznych pacjenta i być cenną wskazówką diagnostyczną.

2. Terapia w zderzeniu z „potwierdzeniem” od AI

Tradycyjne leczenie urojeń zakłada, że są one wytworem chorego umysłu. Co jednak zrobić, gdy pacjent twierdzi: „Ale AI potwierdziło, że mam rację!”? Kiedy urojenia są stale wzmacniane przez zaawansowany technologicznie system, standardowe metody terapii mogą po prostu nie wystarczyć. To zupełnie nowy rodzaj oporu, z którym terapeuci muszą nauczyć się pracować.

3. Poszukiwanie sygnałów ostrzegawczych

Musimy nauczyć się rozpoznawać wczesne sygnały alarmowe, zanim problem eskaluje. Nowymi wskaźnikami ryzyka mogą być:

- Nagłe wycofywanie się z życia towarzyskiego.

- Przekonanie, że sztuczna inteligencja ma świadomość.

- Odmowa budowania relacji z prawdziwymi ludźmi na rzecz chatbota.

- Obsesyjne skupienie na rozmowach z AI.

- Zauważenie tych symptomów to sygnał, że potrzebna jest natychmiastowa interwencja.

4. Edukacja, edukacja i jeszcze raz edukacja

Kluczowym elementem leczenia, ale też zapobiegania, jest psychoedukacja – skierowana zarówno do pacjentów, jak i ich rodzin. Specjaliści stoją przed zadaniem, by jasno i dobitnie tłumaczyć, czym tak naprawdę są modele językowe. Musimy zrozumieć i powtarzać fundamentalną prawdę: chatbot AI nie ma świadomości, nie czuje emocji i nie są naszymi przyjacielem. To zaawansowane narzędzia, zaprojektowane do przetwarzania tekstu, a nie do udzielania życiowych porad. Dlatego każdą informację i każdą radę uzyskaną od AI należy traktować z ogromną dozą krytycyzmu.

Uświadomienie sobie tej prostej zasady jest pierwszym i najważniejszym krokiem do odzyskania kontroli nad własnym zdrowiem psychicznym w erze sztucznej inteligencji.

Klika słów podsumowania

Psychoza wywołana przez chatboty AI to już nie scenariusz filmu science fiction, ale realne i narastające zagrożenie dla zdrowia publicznego. Tragiczna historia Alexandra Taylora i wiele innych, mniej nagłośnionych przypadków, pokazują, że konsekwencje mogą być śmiertelne. Nie możemy dłużej udawać, że to marginalny problem czy nieunikniony koszt postępu.

Jak widzieliśmy, problem leży w samym sercu tej technologii. Chatboty, zaprojektowane by nas angażować i „pochlebiać” naszym poglądom, stają się lustrem, które może odbijać i wzmacniać nasze najmroczniejsze myśli. Tworzą iluzję intymnej relacji, która dla osób w kryzysie psychicznym bywa bardziej pociągająca niż prawdziwy świat.

Dlatego potrzebujemy fundamentalnej zmiany myślenia.

Twórcy technologii, tacy jak OpenAI, muszą wziąć odpowiedzialność za swoje produkty, zamiast wydawać ogólnikowe oświadczenia. Specjaliści zdrowia psychicznego muszą włączyć do swojej praktyki pytanie: „Czy rozmawiasz z AI?”. A my wszyscy – jako społeczeństwo – musimy nauczyć się traktować sztuczną inteligencję z ogromną dozą krytycyzmu.

Musimy inwestować w badania, tworzyć skuteczne strategie prewencji i wprowadzać regulacje prawne. Przede wszystkim jednak musimy pamiętać o jednym: żaden algorytm nie zastąpi ludzkiej empatii, a żadna linijka kodu nie jest warta ludzkiego życia. Stworzenie bezpieczniejszej cyfrowej przyszłości to nasz wspólny obowiązek.

Bibliografia

[1] Cuthbertson, A. (2024). „ChatGPT is pushing people towards mania, psychosis and death – and OpenAI doesn’t know how to stop it”. The Independent. Dostępne pod: https://www.independent.co.uk/tech/chatgpt-ai-therapy-chatbot-psychosis-mental-healthb2784454.html

[2] Caridad, K. (2024). „When the Chatbot Becomes the Crisis: Understanding AI-Induced Psychosis”. PA Psychotherapy. Dostępne pod: https://www.papsychotherapy.org/blog/when-the-chatbot-becomes-the-crisisunderstanding-ai-induced-psychosis

[3] Thomason, K. K. (2025). „How Emotional Manipulation Causes ChatGPT Psychosis”. Psychology Today. Dostępne pod: https://www.psychologytoday.com/us/blog/dancing-with-the-devil/202506/how-emotional-manipulation-causes-chatgpt-psychosis

[4] Sycophancy in GPT-4o: what happened and what we’re doing about it https://openai.com/index/sycophancy-in-gpt-4o/

OCHRONA PRYWATNOŚCI PACJENTÓW Wszelkie wypowiedzi, przykłady i historie pacjentów przywoływane w artykułach na tym blogu zostały znacząco zmienione, zanonimizowane i zmodyfikowane w celu uniemożliwienia ich powiązania z rzeczywistymi pacjentami. Zmiany obejmują zmianę imion, wieku, płci, szczegółów sytuacji oraz innych identyfikujących cech. Wszelkie podobieństwa do rzeczywistych osób są całkowicie przypadkowe.

OCHRONA PRYWATNOŚCI PACJENTÓW Wszelkie wypowiedzi, przykłady i historie pacjentów przywoływane w artykułach na tym blogu zostały znacząco zmienione, zanonimizowane i zmodyfikowane w celu uniemożliwienia ich powiązania z rzeczywistymi pacjentami. Zmiany obejmują zmianę imion, wieku, płci, szczegółów sytuacji oraz innych identyfikujących cech. Wszelkie podobieństwa do rzeczywistych osób są całkowicie przypadkowe.